百度智能云 SGLang Meetup 记录 Link to heading

今天去百了度组织的 SGLang Meetup,看看明星项目都在解决什么问题,在场好多大佬…

全场的目标就是集中在GPU利用率以及推理加速上,勉强全部听下来了,很多名词还需要慢慢消化。记录一下印象比较深的几点:

SGLang 的最新进展 Link to heading

首先是 SGLang 的最新进展, SGLang 支持了 Diffusion,从文本大模型的优化推广到对于多模态的优化,尤其是图片生成。

还有另一块提到比较多的方向就是投机推理,用小而快的草稿模型来预测多个 Token,再由大模型批量验证,达到推理提速的目的。SGLang 提供的 SpecForge 就专门应用于这种场景。

推理集群部署 Link to heading

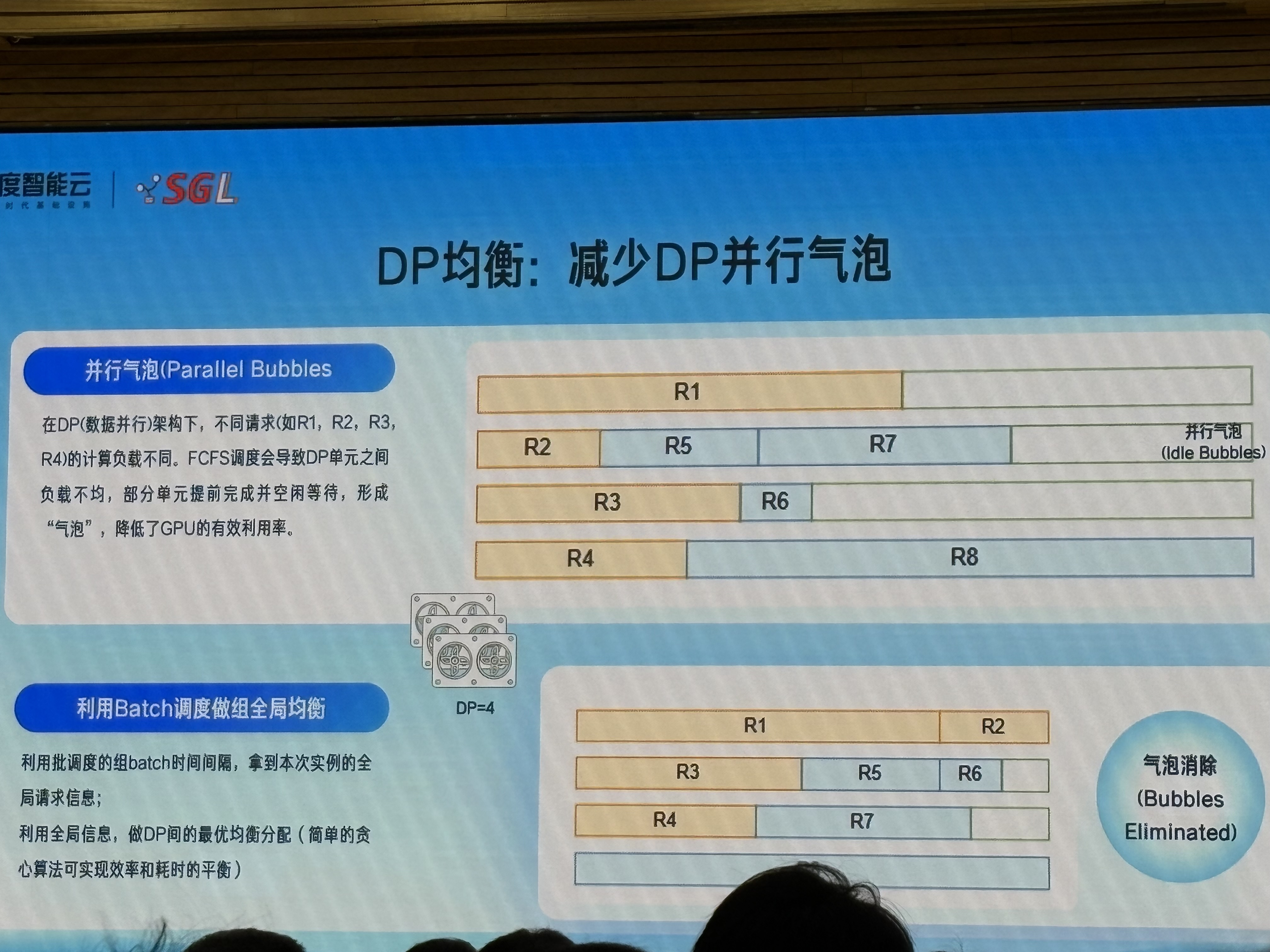

在部署方面,目前优化的方向还是着眼于DP分离架构下的GPU利用率优化,例如用batch调度来做整体均衡调度,减少并行气泡;另外我比较感兴趣的是Prefill和Decode之间的KV Cache通信问题,也许之前的知识能派上用场。

DeepSeek V3 系列 Link to heading

模型适配上面,DeepSeek V3.2 模型受到格外的青睐,厂商在对其进行针对性的优化

喜闻乐见的茶点环节 Link to heading

周边 Link to heading

最后不得不说 SGLang 还是太懂周边,我被这个帆布袋子狠狠拿捏了

.jpg)